Artiste peintre belge: état d'âme N°7.

-

Par amourdelapeinture le 31 Décembre 2011 à 15:04

Les limites de la connaissance 6-8) Conclusion

la cécité empirique.

"La science nous permettra-t-elle un jour de tout savoir? Ne rêve-t-elle pas d'une formule qui explique tout? N'y aurait-il rien qui entrave sa marche triomphale? Le monde deviendra-t-il transparent à l'intelligence humaine? Tout mystère pourra-il être à jamais dissipé?

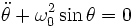

Hervé Zwirn pense qu'il n'en n'est rien.La science, en même temps qu'elle progresse à pas de géant marque elle même ses limites. C'est ce que montre la découverte des propositions indécidables qui ont suivi le théorème de Gödel. Ou celle des propriétés surprenantes du chaos déterministe. Ou encore les paradoxes de la théorie quantique qui ont opposé Einstein et Bohr en mettant en cause toute notre manière de penser.

L'analyse de ces limites que la science découvre à sa propre connaissance conduit à poser une question plus profonde: qu'est ce que le réel?"

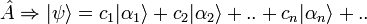

Je voudrais ici faire partager ma lecture de Hervé Zwirn sur "les limites de la connaissance".

Exergue:

"En bref, je défendrai une conception dans laquelle l'esprit ne se contente pas de "copier" un monde qui ne peut être décrit que pas une Seule et Unique Théorie Vraie. Mais je ne prétend que l'esprit invente le monde [...]. L'esprit et le monde construisent conjointement l'esprit et le monde". Putnam (1981)

"Le sens commun mène la physique. La physique montre la fausseté du sens commun. Donc si le sens commun est vrai, alors il est faux. Donc le sens commun est faux." Bertrand Russel.

1) préambule.

science et vérité. ubirdt saint-esprit

Dans le message précédent qui présente les positions et attitudes philosophiques face aux résultats de la physique quantique, nous avons vu qu'aucune ne peut se prévaloir d'être l'unique conception mais chacune peut faire valoir des arguments convaincants en sa faveur. A ce stade, les attentes philosophiques, voire "psychologiques" de chacun diffèrent et ce qui peut sembles convaincant aux uns paraîtra inepte aux autres. Pour aller plus loin, il faut conserver la cohérence de l'argumentation et le consistance de l'analyse. Je partage ici l'avis de Hervé Zwirn dans le refus de deux positions opposées. J'expose la lecture que j'en fait aujourd'hui et qui n'engage que moi.

a) Celle du réalisme scientifique (traditionnel).

Il consiste à penser qu'il existe une réalité indépendante dans laquelle l'homme est immergé et qu'elle est correctement et littéralement décrite par la physique. Cette physique n'est pas celle d'aujourd'hui, mais celle d'une hypothétique théorie ultime vers laquelle la science tend asymptotiquement. Réalité indépendante: elle existerait de la même manière et sous forme identique même en l'absence de tout être humain. Exister: le verbe est à prendre ici dans son sens littéral le plus immédiat, identique à celui du langage courant (le papier sur lequel est imprimé ce livre existe). Mais la physique montre que le sens commun a tort de croire que ce papier existe,seules existent vraiment les entités utilisées dans la théorie, par exemple les champs. Donc entre le langage courant et le langage scientifique, le verbe "exister" ne change pas de sens, seules changent les entités qui peuvent prétendre à l'existence. L'homme est un élément de cette réalité dans laquelle il est immergé et qu'il ne perçoit pas directement dans sa globalité. Cette limitation ne concerne que cette perception et n'a aucune influence sur la réalité elle-même. La physique décrit la réalité telle qu'elle est vraiment et les affirmations des théories sont à prendre à la lettre comme le dit Van Fraassen:"...alors il y a réellement des électrons qui se comportent de telle et telle manière."

Si la réalité ne nous apparaît pas directement en raison de la limitation de nos sens, la physique nous donne les moyens de comprendre l'apparence qu'elle revêt pour nous. Actuellement, cette réalité peut être décrite comme un espace-temps à 10 dimensions dans lequel interagissent des champs de cordes supersymétriques, espace et champ de cordes qui existent en tant que tels. Si nous ne percevons que 4 dimensions dans notre monde perceptible, cela provient de l'enroulement de 6 des 10 dimensions sur une distance de l'ordre de 10puiss-33 cm, "compacification" des dimensions qui rend impossible leur perception directe.

En conclusion du réalisme scientifique: "même si le contenu des théories change, le principe sous-jacent restera du même type, des objets (abstraits, complexes et non représentables) sont les briques de base à partir desquelles tout ce qui constitue notre environnement habituel est construit. Le réalité est le niveau où vivent ces briques. L'homme est immergé au sein de cette réalité et sa réalité phénoménologique est une représentation, forcément partielle et limitée de cette réalité indépendante. La réalité phénoménale dépend des capacités perceptives humaines mais pas la réalité indépendante dans laquelle l'Homme est immergé et qu'il découvre conceptuellement. Cette réalité indépendante épuise tout."

b) Celle de l'idéalisme radical.

"Tout est création de l'homme et rien n'existe en-dehors des phénomènes perceptifs. La "réalité" (au sens du chapitre précédent) n'a aucune existence et n'est qu'une reconstruction pragmatique destinée à organiser nos perceptions." Le solipsisme, qui pose que seul un esprit (le mien) existe et que tout n'est que création de cet esprit, en est la version la plus extrême.

c) Objections à l'encontre du réalisme scientifique..

En raison de la sous-détermination des théories par l'expérience, plusieurs théories ultimes mutuellement incompatibles mais adéquates peuvent être plausibles. Alors, comment soutenir l'existence d'une réalité unique? De plus, le concept de réalité indépendante est mis en difficulté par l'impossibilité de construire une théorie ontologiquement interprétable et il semble impossible de soutenir que les objets des théories sont les constituants d'une réalité ayant une existence autonome et indépendante, même si nous disposions d'une théorie ultime totalement adéquate avec les phénomènes.

d) Objections à l'encontre de l'idéalisme radical.

Il ne se se heurte pas à des objections du même type, en en sens il est non réfutable. Le solipsisme pur et dur (seules mes propres perceptions existent, tout en étant que construction de mon esprit) est logiquement possible. Il n'est pas à rejeter seulement en raison d'objections du genre "si tout n'est qu'invention de mon esprit, pourquoi ne suis-je pas milliardaire?" car rien n'indique en effet que je devrais être capable de contrôler le processus de création, après tout, je ne contrôle pas mes rêves. De plus, si l'esprit est régi par des structures, des phénomènes de limitation analogues à ceux des systèmes formels peuvent survenir pour empêcher toute construction.

L'idéalisme non solipsiste se contente de refuser l'existence réalité dont les perceptions seraient l'image. L'intersubjectivité pourrait poser une difficulté à cette position, mais elle pourrait n'être qu'une illusion comme c'est le cas dans le solipsisme convivial. L'argument de la résistance du réel lui non plus n'est pas déterminant, car une construction, ici celle ne notre esprit, est toujours soumise à des contraintes si elle est est régie par des règles. Par contre, une vraie difficulté est de considérer la perception comme antérieure à l'existence. Comment accepter une perception sans existence d'un sujet percevant? Cela est sans doute possible si on admet la pensée comme unique existant, mais est-ce satisfaisant? De plus, on n'est pas plus avancé que dans le cas du solipsisme.

e) Position défendue par H. Zwirn, que je partage.

L'homme n'est pas créateur du monde, mais il n'est pas un observateur passif. Ains que le dit Putnam en exergue à ce chapitre, "L'esprit et le monde construisent conjointement l'esprit et le monde". C'est une manière de refuser le face de l'Homme et de l'Univers du réalisme traditionnel.

2) Rejet des arguments en faveur du réalisme.

Galilée

a) arguments en faveur du réalisme métaphysique.

*L'argument que Hume a appelé "la relation cause-effet": si j'entends des voix dans la pièce voisine, j'en infère que qu'il y a des personnes qui y sont présentes; Si je vois une forme ressemblant à un plateau, j'en infère qu'il y a une table devant moi. On peut y distinguer deux éléments différents. Le premier consiste à inférer d'une perception une autre perception potentielle par un raisonnement contre-factuel: si j'allais dans la pièce voisine, je percevrais des personnes. Il ne concerne que la réalité empirique et relie les perceptions entre elles. La critique de Hume porte sur le fait que ce lien entre les perceptions (le premier élément), ne peut être établi sans postuler la validité du principe d'induction qui nous garantit que s'il s'est révélé exister dans le passé, il existera dans le futur. Or, il est impossible de justifier rationnellement le principe d'induction. Le deuxième consiste à inférer l'existence d'une entité réelle, une table, à partir de la perception qu'on en a. Il concerne la réalité en soi (hypostasier des entités en tant qu'explication des perceptions), et seul ce élément concerne le réalisme métaphysique alors que le premier est plutôt une condition nécessaire à la construction de tout discours empirique.

Hume a combattu l'idée qui consiste à considérer que lorsque nous avons la perception visuelle et tactile d'une forme de plateau avec 4 pieds, la meilleure explication possible est l'existence réelle d'une table qui en est la cause, en soulignant que nous n'avons accès qu'à nos perceptions et aucunement à la réalité en soi. L'hypothèse de l'existence réelle d'objets réels extérieurs ne s'impose donc nullement, ce n'est qu'un moyen pragmatique d'organiser nos perceptions. La critique de Hume est fondée et rien n'autorise de manière péremptoire à passer de l'existence de nos perceptions à à celle d'un monde extérieur (la physique quantique confirme ce genre d'objections). La relation cause-effet n'es donc pas un argument pertinent pour justifier la réalité en soi.

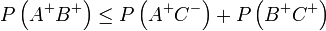

*L'intersubjectivité.

C'est un argument en faveur de l'existence d'objets extérieurs à nous-même, car si comme le suppose l'idéalisme, rien n'existe en dehors de nos esprits, ce dernier est bien en mal d'expliquer pourquoi nous tombons d'accord sur nos perceptions. Si Jean et Marie s'accordent à dire qu'il y a deux verres et une bouteille de vin sur la table, l'explication la plus simple est de considérer qu'il y a réellement deux verres et un bouteille. Cet argument prolonge celui du chapitre précédent et répond à une objection, car si j'ai la perception d'une table, cela ne veut pas dire forcément qu'il y a une table devant moi, je pourrais être victime d'une illusion, la table pourrait n'exister que pour moi. En revanche, si Jean et Marie sont d'accord, la table n'existe pas que pour un seul esprit. Ils pourraient être victimes de la même illusion, mais il serait difficile de soutenir que tous les cas de perceptions communes sont des illusions partagées.

L'intersubjectivité semble donc un argument plus solide celui de la relation cause-effet. la mécanique quantique va à l'encontre de cette conclusion. Ce n'est pas parce que Jean et Marie s'accordent sur le fait que le spin suivant une direction est +1/2, qu'il vaut +1/2 avant la mesure. L'explication intuitive que ce résultat préexistait à la perception n'est pas valide. De plus, la mécanique quantique fournit le mécanisme qui explique que tous deux tombent d'accord bien que le résultat ne préexiste pas à leur perception. L'intersubjectivité n'est donc pas un argument pour suffisant pour imposer une réalité externe comme cause des perceptions, elle dit au contraire que l'acte de percevoir cause, au moins en partie, la nature de la perception., ce qui apparaît clairement dans la théorie de la décohérence. En effet, celle-ci dit que le système perçu reste dans un état superposé et ce n'est que la perception que nous en avons qui paraît réduite. De plus, ceci admet que lorsque deux observateurs sont d'accord sur leurs perceptions, celles-ci sont effectivement identiques. Mais ce n'est pas obligatoire, car dans l'interprétation du solipsisme convivial, il est possible que l'intersubjectivité soit apparemment respectée sans que les perceptions des différents sujets soient les mêmes. Celle-ci ne peut donc pas être utilisée comme un argument en faveur de de l'existence d'une réalité externe cause des perceptions.

*La résistance au réel.

Si le réel n'était que construction humaine, il n'y aurait aucune raison que les théories les mieux construites soient contredites par l'expérience. Or l'histoire des sciences montre nombre de "belle théories", fécondes et puissantes, ont été réfutées par "quelque chose qui dit non" (et qui ne peut pas être "nous") selon l'expression de Bernard d'Espagnat. Cet argument suppose implicitement qu'une construction humaine sera "sa propre mesure" et ne se heurtera à aucune contradiction. Dans cette approche, on suppose que tout est construction humaine, que nous inventons les règles. Les théories sont ce qu'on pourrait appeler des constructions explicites, conscientes et formelles destinées à rendre compte d'une "construction perceptuelle" inconsciente qui serait cette construction humaine: le réel. Alors, étant donné ce que nous avons vu sur la consistance des systèmes formels, il i'y a rien d'étonnant à ce que nous constations des désaccords et des contradictions entre les deux constructions, nos constructions théoriques et ce que nous appelons le réel. En fait, nous ne savons pas édifier de construction paradigmique consistante. Les contradictions seront éliminées par une modification dialectique des théories et de ce que nous appelons le réel (celui de la physique newtonnienne n'est pas celui de la physique quantique). La résistance du réel n'est donc pas un argument convaincant de postuler la résistance d'une réalité extérieure.

*Préexistence de quelque chose qui connaît à la connaissance.

Bernard d'Espagnat l'a présenté comme une nécessité logique: si on parle de connaissance; il faut bien que quelque chose connaisse. L'existence ne peut donc procéder de la connaissance. Bonsack, pourtant proche de certains points de vues de d'espagnat , adopte le point de vue opposé, la point de vue "épistémologique", par contraste avec ce point de vue "ontologique". Il consiste à rendre compte de la façon dont le sujet est amené à postuler l'existence à partir du flux perceptif. De plus, il n'est pas impossible que le seul existant soit le pensée. Cet argument, bien que de bon sens n'est donc pas définitivement probant.

b) Arguments en faveur du réalisme épistémique.

Ces arguments prennent place dans un cadre acceptant l'existence d'une réalité extérieure.

*L'argument du succès empirique est un point essentiel des défenseurs du réalisme épistémique: comment nos théories pourraient-elles être empiriquement adéquates si elles ne décrivaient pas, au moins partiellement des entités et des mécanismes réels? Il serait alors miraculeux qu'elles parviennent à décrire et prédire cette réalité empirique. Cet argument plaide aussi indirectement en faveur du réalisme métaphysique puisqu'il s'appuie nécessairement sur l'existence d'une réalité extérieure. Sa séduction exerce un force d'attraction dont il est difficile de s'affranchir, sans doute dû au fait que le mécanisme psychologique qui nous y fait adhérer joue un rôle important dans notre fonctionnement quotidien et qu'il s'est exercé dès l'enfance. Simplifié à l'extrême, cela revient à expliquer que nous voyons l'herbe verte parce qu'elle est réellement verte. Mais on a vu précédemment que c'est une fausse explication qui soulève plus de difficultés qu'elle n'en règle. Par ailleurs, on ne peut soutenir qu'une théorie empiriquement adéquate à un moment est vraie, l'histoire regorge de telles théories qui ont été ensuite réfutées et un raisonnement inductif pessimiste incite à penser que cela sera faux également pour les théories actuelles. On pourrait, à l'instar de Boyd adopter un concept de vérité approximative, mais ce concept est insatisfaisant et ne résout pas le problème.

La situation imagée donnée par Hervé Zwirn est parlante. Imaginons que Monsieur R le réaliste) nous présente une théorie T empiriquement adéquate (au sens où toutes ses prédictions ont été réalisées, mais aussi où toutes ses prédictions futures le seront): c'est parce que T est vraie (que tous les objets dont elle parle existent réellement et que les lois qu'elle utilise correspondent à des mécanismes ou à des contraintes qui reflètent le structure de la réalité telle qu'elle est vraiment). Cette histoire est supposée avoir lieu dans un monde futur où la science aura progressé à tel point que que cette théorie a pu être construite et vérifiée depuis des générations. Ce n'est pas le cas de la physique quantique, car même si elle a notre confiance, nous savons qu'elle doit être généralisée pour tenir compte à la fois de la relativité restreinte et de la relativité générale. Cela pourrait être le cas de la "théorie du tout" que certains physiciens pensent être à notre portée prochainement grâce à aux théories des supercordes. Ainsi on pourrait échapper à l'objection concernant les théories empiriquement adéquates et réfutées ensuite? Si nous acceptons que T est empiriquement adéquate pour les observations passées, qu'est ce qui permet à Monsieur R de croire que que cette adéquation persistera dans l'avenir (nous avons vu toutes les objections au sujet de l'induction)? Sa réponse pourrait être: si l'adéquation passée de T ne peut s'expliquer autrement que par le fait que est vraie, (sinon ce serait un miracle ou une suite invraisemblable de coïncidences favorables); or, si T est vraie, son adéquation empirique dans le futur est certaine. En effet, si une observation a venir était en désaccord avec les prédictions de T, c'est que le phénomène réel sous-tendu par cette observation serait différent d'une façon ou d'une autre de ceux décrits par T et donc que T n'est plus vraie. Donc si T est vraie, dans ce sens, elle est vraie de toute éternité, presque par définition. On atténue ainsi le problème de l'induction, mais cela présuppose d'accepter la vérité de T.

Dans ce schéma, adéquation empirique et vérité deviennent équivalentes: 1) T a été empiriquement adéquate dans le passé. 2) La seule explication possible est que T est vraie. 3) T sera donc empiriquement adéquate dans le futur. Cependant le point 2) est réfuté en raison de la sous-détermination des théories car il est possible qu'il existe une ou plusieurs théories T' empiriquement équivalentes à T mais incompatibles avec elle. Il est impossible qu'elles soient simultanément vraies dans le sens adopté par Monsieur R dont la position n'est donc pas justifiée. Une autre critique est basée sur le fait que qu'étant donné un nombre limité d'observations, il existe un grand nombre, voire une infinité de théories capables de décrire correctement ce ensemble; il n'y a donc pas à s'étonner du fait que nous sommes capables de construire des théories adéquates à un instant. On pourrait dire que c'est non la description des données connues, mais la prédiction de faits nouveaux qui serait miraculeuse si rien dans la théorie ne correspondait à quelque chose de réel (l'exemple souvent cité est la découverte de Neptune). Mais il ne faut pas retenir que les succès et oublier les échecs. La découverte de Neptune est un succès considérable pour la mécanique newtonnienne, mais l'inexistence de Vulcain, censé expliquer la précession du périphélie de mercure est un échec tout aussi considérable. C'est ainsi que celle ci est réfutée par l'invention de la relativité générale.

La science progresse, selon Popper par essais et erreurs, conjectures et réfutations. Dans le nombre de théories empiriques disponibles (fini) dans l'infinité de théories différentes, voire incommensurables ou contradictoires, il arrive qu'un certain nombre sont en compétition à une époque. Parmi celles-ci, des tests supplémentaires permettent parfois d'en dégager certaines qui font des prédictions incompatibles. C'est, dit Hervé Zwirn, le cas de la théorie de Brans et Dicke écartée récemment en tant que concurrente de la relativité générale. Dans le cas de la théorie newtonnienne, la prédiction vérifiée et la découverte de Neptune avaient été comptées comme un argument fort en sa faveur. Un autre exemple est celui du modèle de Weinberg-Salam unifiant les interactions faibles et électromagnétiques. Elles étaient en concurrence avec d'autres théories avant que les bosons intermédiaires soient découverts et permettent leur survivance. A postériori, il semble miraculeux que ces théories aient fait ces prédictions. Mais il n'est pas étonnant que l'une d'entre elle se révèle momentanément correcte. A d'autres moments, aucune des théories en présence ne réussit à prendre en compte les faits nouveaux observés et il faut construire une nouvelle théorie. C'est un changement de paradigme (voir la relativité générale et la physique quantique). Il n'y a pas à s'étonner du "miracle" de la prédiction de faits nouveaux, ce n'est qu'une surprise psychologique comparable à celle qu'on éprouve après avoir parcouru un long chemin dans un labyrinthe et avoir éliminé toutes les impasses.

L'argument de Monsieur R semble donc peu convaincant, rien ne semble justifier la nécessité d'une correspondance entre concepts théoriques et entités réelles pour rendre compte de l'adéquation empirique des théories. Mais le réalisme structurel défendu par Worral, dans le contexte où on admet une certaine réalité, peut être une tentative d'explication de la réussite des théories moins sensible aux objections.

TOUTES LES CHOSES SONT RELIEES LES UNES

AUX AUTRES PAR LA CAUSE ET L'EFFET.

UN ACCIDENT N'EXISTE PAS.

*La relation cause-effet.

Nous venons de voir que la première forme de cet argument est liée au principe d'induction: de la régularité de certaines associations dans le passé, on infère qu'elles se reproduiront dans le futur. Ce raisonnement est à la base même de toute prédiction, scientifique ou pas. Le critique de Hume est rationnellement fondée et on ne peut justifier ce principe sans recourir à un autre principe similaire. Russel cite l'exemple du poulet qui associe la main du fermier avec la nourriture qu'il lui donne jusqu'au jour où cette main lui tord le cou. Mais si cependant l'induction ne fonctionnait pas un peu, le monde serait différent de ce qu'il est, aucune connaissance ne serait possible puisque rien ne se répéterait. Mais en voyant l'ensemble des observations qui ont été faites, l'induction a fonctionné suffisamment souvent pour que la probabilité qu'elle ne fonctionne pas dans le futur est faible. Cependant, un tel raisonnement, faisant appel lui aussi à un principe d'induction est vicié par nature.

Le scepticisme radical de Hume, pris au pied de la lettre, interdit toute confiance dans un discours prédictif et elle interdit de rendre compte de l'activité humaine autrement qu'en considérant qu'elle est irrationnelle. Pour éviter cette difficulté, Kant a postulé que l'induction est une catégorie à priori de l'entendement. En ne retenant pas le critique de Hume, il semble cependant qu'il faut éviter l'argument cause-effet pour justifier une quelconque correspondance réelle entre le "discours" et "le monde". L'induction vient de nous et ne nous donne aucune indication sur la nature de d'une éventuelle réalité.

c) Que reste-t-il alors pour défendre la réalité?

Aucun des argument habituels en faveur de l'existence d'une réalité en soi, indépendante de toute connaissance ou de toute "interférence humaine" ne paraît véritablement contraignant et il ne semble nullement obligatoire que les entités théoriques et les mécanismes ou les lois du discours scientifique doivent nécessairement avoir un correspondant réel. On peut retenir néanmoins une version du réalisme structurel comme explication de la réussite partielle des théories jugées empiriquement adéquates à un instant. Si on rejette l'idéalisme radical, on peut alors adopter provisoirement une position proche de d'Espagnat, qui consiste à admettre l'existence de quelque chose qui procède en partie de l'esprit humain bien que n'en n'étant pas une pure émanation, qui cause la réalité empirique et dont les structures se reflètent d'une certaine manière dans les théories scientifiques qui réussissent.

3) Esquisse d'un scepticisme épistémologique. position présentée par H. Zwirn, que je partage dans cette approche de réflexion).

a) la cécité empirique: première approche.

L'analyse de l'empirisme logique (voir cet article) a montré qu'il n'existe pas d'énoncé purement observationnel et derrière le mot empirisme se cache une imbrication de concepts théoriques et d'observations. Accepter de reconnaître qu'une théorie T a été jusque là empiriquement adéquate, c'est manifester déjà un certain engagement vis à vis de T et accepter le cadre conceptuel qu'elle définit pour interpréter les observations faites. c'est accepter que l'ensemble des observations faites, nécessairement guidées par le programme de recherches induit par T, constitue un ensemble significatif (au sens d'échantillon statistiquement significatif) par rapport à toutes les observations possibles et dont certaines départageraient T des théories concurrentes. C'est aussi considérer que T est empiriquement pertinente, c'est à dire qu'elle induit un cadre conceptuel qu'on juge adapté pour engendrer un programme de recherche qui guidera les expériences à faire pour la tester. C'est donc le premier pas pour entamer un programme qui conduira à sa confirmation ou à sa réfutation. Mais cet engagement ne peut être justifié que si la structure de T ne s'éloigne pas trop du paradigme dominant sur le type de bonnes théories et si T peut se prévaloir d'un certain nombre de succès à son actif (par un fait précédemment inexpliqué ou par la prévision réussie d'un fait nouveau). Il y a alors renforcement de notre confiance qui en retour nous conforte sur les bons indices de l'adéquation empirique de le théorie. C'est conforme au processus décrit par Boyd: "il existe une relation dialectique entre la théorie courante et la méthode utilisée pour son amélioration."

Boyd y voit une condition de possibilité d'un développement réaliste de la science c'est plutôt un argument qui montre que l'adéquation empirique n'est pas des plus solides. Ce processus réflexif, lorsqu'il est fructueux, peut converger vers l'acceptation conjointe de de la pertinence et de l'adéquation empirique. Cependant est-ce une garantie réelle? Un tel processus, enclenché dans une mauvaise direction, pourrait entretenir à tort son propre succès.

Une première manière consiste à fournir des précisions suffisamment vagues pour que, quelque soit le résultat de l'expérience, il soit jugé conforme aux prévisions ou à ne retenir que les résultats qui confirment les prévisions (l'astrologie telle qu'elle est pratiquée de nos jours, en est un exemple). Un deuxième manière consiste à recourir à des hypothèses ad hoc pour rendre compte d'échecs prédictifs. Popper les appelle des "stratégies auto-immunisatrices". Cela pose le problème de savoir ce qu'est une bonne méthodologie scientifique. Il n'existe aujourd'hui aucun moyen rigoureux de définir ce qu'est une authentique théorie scientifique, mais malgré l'absence de critères explicites, les progrès méthodologiques nous permettent d'éliminer assez sûrement les théories manifestement déviantes qui utilisent les méthodes décrites précédemment.

Une troisième manière, plus subtile d'entretenir faussement un succès empirique consiste en ce que la théorie induise un cadre conceptuel tel qu'aucune expérience qui pourrait être de nature à le réfuter ne soit menée: c'est un premier aspect de "la cécité empirique". Un exemple caricatural est de s'imaginer une terre jumelle qui existe dans un univers newtonien. Sur cette terre 2, les lois de la nature sont décrites en gros par la physique newtonienne du temps de Laplace. Le programme de recherche est exclusivement centré sur le comportement des objets macroscopiques et reste aveugle aux autres phénomènes que nous connaissons. La théorie dominante est empiriquement adéquate puisqu'on se borne à l'utiliser dans son domaine de réussite et on ne considère comme scientifique que les expériences qui portent sur ce domaine et rien que sur ce domaine. Pour les physiciens réalistes de cette terre 2, la théorie newtonienne est don vraie. Dans cette situation, l'adéquation empirique induite par la théorie provient d'une mauvaise pertinence empirique de la théorie. Le programme induit par la théorie a conduit les physiciens à une cécité empirique les empêchant de faire les expériences nécessaires pour la réfuter, comme par exemple celles consistant à faire interférer deux rayons lumineux ou à étudier le spectre du corps noir.

Il est certes facile d'élever des objections contre cet exemple, mais elles ne sont pas probantes. La première est que dans un monde où il n'y a pas de place pour le relativité restreinte, les lois de la nature seraient tellement différentes que des nôtres que le monde pourrait bien être comment le supposent les physiciens de la terre 2. A cette objection, on peut répondre qu'il qu'après tout, il est possible d'accepter un monde où tout est comme chez nous à l'exception des lois relativistes. La deuxième objection concerne le fait qu'on pourrait supposer que les physiciens de la terre 2 ne se posent aucun problème concernant la lumière et que l'électricité ou le magnétisme n'ont pas été découverts. Mais sur cette terre 2, l'électricité et le magnétisme existent et par conséquent, les physiciens devraient s'être rendu compte. Cette objection provient du fait qu'on pense généralement qu'il n'est pas possible de passer à côté de la lumière ou du magnétisme. Mais ce qui est mis en évidence ici, c'est le fait qu'un programme de recherche induit par une théorie dominante peut très bien conduire à oublier de remarquer certains phénomènes de nature non évidente. Les expériences mises en oeuvre pour vérifier les inégalités de Bell ne s'imposent pas spontanément à un expérimentateur, il faut un travail théorique préliminaire complexe. Il en est de même pour la non-séparabilité. Il a fallu le génie de Bell pour y parvenir alors que ni Einstein ni bohr, pourtant préoccupés par le sujet, n'ont été capables d'imaginer une expérience réelle susceptible de la mettre en évidence.

Il n'est donc pas absurde de penser que de tels phénomènes complexes qui pourraient, s'ils étaient testés, soient dissimulés à l'intérieur du cadre d'une théorie. Dans ce cas, la théorie ne rencontrera aucun démenti alors qu'elle sera empiriquement fausse. C'est bien ce qui s'est passé lorsque le programme de recherche de la physique a conduit à se concentrer sur les systèmes intégrables. Durant toute une période, elle a oublié d'expérimenter sur les systèmes chaotiques, laissant croire à des générations de physiciens que le monde était intégrable, alors qu'on sait maintenant que la majorité des systèmes dynamiques est chaotique.

La cécité empirique, sous cet aspect, est le fait d'être aveuglé dans son champ de recherche par un programme issu d'une théorie dominante bornée (qui a des bornes), de telle sorte que certaines parties de la réalité empirique restent ignorées du discours théorique et des préoccupations scientifiques. Elle est donc liée à la non-pertinence d'une théorie et doit rendre prudent quant aux affirmations portant sur l'adéquation empirique et ne pas lui conférer un statut de certitude trop fort. Ainsi, à aucun moment nous ne disposerons d'une théorie adéquate décrivant la totalité de la réalité empirique car cette dernière débordera toujours de l'ensemble des concepts disponibles. C'est un "maladie" inévitable quelles que soient les avancées et les découvertes qui interviendront dans le futur.

b) Le concept de vérité et la sous-détermination empirique des théories.

Beaucoup de conceptions réalistes sont fondées sur le concept de vérité-correspondance: un énoncé est vrai en vertu du fait qu'il exprime un état de chose qui lui correspond. Dans l'approche réaliste traditionnelle, une théorie (empiriquement adéquate) est vraie si et seulement si ses énoncés correspondent à des états de fait de la réalité, de la même manière que le récit fidèle d'un film nous permet de savoir ce qui s'est réellement passé dans ce film. Mais contrairement à un film où on ne peut avoir deux récits fidèles et contradictoires, la sous-détermination des théories pose problème car il est possible que deux théories contradictoires soient adéquates. Prenons l'exemple de deux théories qui postulent l'une des entités ponctuelles et l'autre uniquement des entités arbitrairement petites mais jamais ponctuelles. Laquelle est alors vraie? y a-t-il ou non des entités réellement ponctuelles?

Pour un instrumentaliste, cette question n'a pas de sens: elles ne sont pas en contradiction sur ce qu'elles disent, puisqu'il est impossible de les distinguer empiriquement mais sur la manière dont elles le disent. Le concept d'une vérité, au sens habituel du terme, est donc remis en cause. Si on adopte le point de vue qu'une théorie se réduit à son adéquation empirique, alors on se trouve forcé d'admettre que pour qu'une question n'ait pas de sens, il suffit que deux théories adéquates équivalentes lui donnent une réponse différente. La question se trouve alors rejetée au métaniveau, elle ne porte plus sur le monde, mais sur notre manière d'en parler. Un électron suit-il une trajectoire définie? non en mécanique quantique, oui dans la théorie de Bohm.

Les instrumentalistes sont prudents et ne vont pas jusque là, mais leur position concernant la vérité n'est sans doute pas justifiée. En fait, nos théories doivent être considérées seulement comme un moyen commode (des algorithmes) pour parler des phénomènes et les prédire. Des questions grammaticalement construites pour pour porter sur la réalité sont dépourvues de sens. Les concepts doivent considérés comme des outils internes à la description sans référent dans la réalité. Ils ne sont pas absolus puisque un autre langage peut ne pas les utiliser mais néanmoins arriver au même degré d'efficacité prédictive.Une analogie peut éclairer cette difficulté: Le Français et l'anglais sont équivalents pour parler des arbres; en français le mot arbre possède 5 lettres alors qu'il en possède 4 en anglais. La question "est-ce qu'un arbre possède 5 lettres?" est dépourvue de sens, le nombre de lettres n'est par une propriété des arbres. Une erreur de même nature (mais moins facilement détectable) est commise dans le cas de certaines questions portant sur des entités théoriques de la physique: par exemple, un électron suit-il ou non une trajectoire définie? On a vu que que le concept de trajectoire a un sens dans la théorie de Bohm, mais pas en mécanique quantique. Ce n'est donc pas une propriété des électrons mais seulement des outils formels qu'une théorie particulière utilise pour parler des électrons.

Ce constat peut-il se comprendre? Le langage courant nous autorise à croire que la trajectoire appartient vraiment aux objets de la réalité. Le processus d'apprentissage que suit tout être humain à partir de la petite enfance évolue vers un stade préscientifique dans lequel se forgent les représentations mentales qui lui servent à ordonner ses perceptions. L'unique théorie à ce stade préscientifique et pré-épistémologique est le langage courant. L'image intuitive est le plus souvent construite dans un cadre réaliste naïf et les entités du langage sont considérées comme se référent à une réalité extérieure. Il en résulte une relation biunivoque entre la description du langage et les objets de la réalité ainsi construite. Les propriétés des objets leur sont attribuées en propre. Il est souvent impossible de faire, à ce stade, la différence entre propriété des objets et propriété des outils utilisés pour en parler (sauf quand c'est évident comme dans le cas des arbres ci-dessus). Ce n'est que lorsque le langage courant ne suffit plus pour décrire et prédire les phénomènes plus complexes que la différence peut apparaître (avec les théories scientifiques formalisées) et ce n'est pas facile tant est grande la tentation de projeter les propriétés des entités théoriques sur les référents postulés de ces entités. Alors, la majorité des chercheurs préfère se placer dans le cadre de la théorie dominante pour la perfectionner plutôt que de se lancer dans la recherche de formalismes différents produisant les mêmes prédictions. C'est ce que Kuhn appelle la phase de recherche "normale" qui ne prend fin qu'avec l'apparition de difficultés qui peuvent aboutir à un changement de paradigme.

Mais une recherche de théories empiriquement incompatibles pourrait peut-être permettre de déceler la non-pertinence de certaines questions sans réponse et de comprendre pourquoi certaines questions n'ont pas de sens (comme la simultanéité de deux évènements ou des questions traitées dans les théories modernes de cosmologie quantique). Mais il nous faut abandonner l'idée selon laquelle une théorie adéquate fournit une description littéralement vrai de la réalité et admettre que de nombreuses questions apparemment sensées portant sur la réalité ne sont que de fausses interrogations car elles portent en fait sur des aspects purement internes des théories utilisées pour la décrire.

c) Les théories scientifiques comme algorithme de compression.

La théorie algorithmique de l'information, inventée par Kolmogorov, Solomonov et Chaitin, permet de voir les théories scientifiques sous un angle qui éclaire ce qu'on vient d'examiner. La complexité algorithmique d'une chaîne de bits est donnée par la taille du plus petit programme autodélimité capable d'engendrer cette suite. par exemple, la complexité de la chaîne infinie d'une suite de 0 et de 1 est faible car elle peut être être engendrée par le programme: "faire suivre alternativement 0 et 1 à l'infini". Mais s'il est possible de trouver un programme d'engendrement de longueur plus courte que celle de la suite, celle-ci est "aléatoire", en fait, la suite n'est régie par aucun algorithme. Elle contient une beaucoup plus grande quantité d'information qu'une suite qui ne l'est pas. Une suite non aléatoire contient des redondances qui peuvent être compactées et c'est justement ce qui permet d'expliciter un algorithme qui l'engendre.

Le concept de complexité algorithmique peut être étendu aux systèmes formels. Un système formel ne peut démontrer aucun énoncé dont la complexité est supérieure à celle de son système d'axiomes (dans ce cas, l'énoncé sera indécidable). Les résultats expérimentaux d'une peuvent être considérés comme un ensemble d'énoncés appartenant au langage de la théorie puisque la théorie est destinée à les décrire et à les prédire. La théorie, s'il elle est adéquate, est un moyen d'engendrer l'ensemble de ces résultats. Sur un plan purement formel et si on ne considère que les résultats expérimentaux sous leur aspect dénoncés de ce langage, on peut considérer la théorie comme un algorithme permettant d'engendrer l'ensemble de ces énoncés. On peut dire que le domaine de la science est le domaine des phénomènes qui se laissent décrire par de tels algorithmes, ce qui n'est pas le cas de l'art par exemple. Il est impossible de produire un algorithme engendrant des symphonies grandioses ou des tableaux. Ce n'est pas le cas de la psychologie, nous ne savons pas prédire les états affectifs des êtres humains. On est alors moins tenté d'être étonné que le monde de la physique soit compréhensible (comme l'a fait Einstein) ou trouver extraordinaire que les mathématiques sont soient si efficaces comme l'a fait Wigner. Nous ne savons appliquer la science qu'aux domaines où elle est applicable, celui des phénomènes mathématiquement compressibles qui se laissent engendrer par des algorithmes. Les seuls phénomènes que nous considérons comme scientifiques sont ceux-là (à l'exclusion de l'esthétique, de l'affectif...). Nous sommes comme l'ivrogne de l'histoire qui cherche ses clés sous la lampe, non parce que c'est là qu'il les a perdues mais parce que c'est le seul endroit où il y a de la lumière. Le seul étonnement qu'on devrait avoir, c'est de s'émerveiller qu'il reste de tels domaines. Tout dans le monde pourrait n'être que processus aléatoire non compressible, art, affectivité et dans ce cas la science n'existerait pas.

Si les théories sont considérées comme des algorithmes, il est compréhensible qu'il soit possible de trouver plusieurs théories empiriquement équivalentes. Un algorithme n'est jamais unique, d'où les recherches pour trouver les plus performants. Deux algorithmes en font pas appel aux mêmes intermédiaires de calcul. On se trouve donc face à une contradiction si on attribue à ces derniers un référent réel puis qu'on ne postulera pas l'existence de mêmes objets selon l'algorithme qu'on adopte. On peut objecter que si ces intermédiaires posent problème, les entités que que les deux algorithmes sont supposés engendrer doivent une existence réelle puisque les deux algorithmes les produisent. Les prédictions empiriques portent sur perceptions qu'on peut penser réelles, mais postuler l'existence d'objets réels cause de nos perceptions se heurte à aux objections à la deuxième forme de la relation cause-effet que nous avons signalées précédemment.

En conclusion, se représenter les théories physiques comme de simples algorithmes permettant de prédire les résultats empiriques permet de mieux comprendre les réserves sur le réalisme métaphysique et le réalisme épistémique. Les limites de démontrabilité des systèmes mathématiques permettent d'envisager que la possibilité que certains énoncés soient hors de portée de toute prédiction d'une théorie physique.

le principe d'identité et d'indécidabilité !

d) Une application empirique de l'indécidabilité.

Un éventuelle "théorie du tout" permettra-t-elle , au moins en principe de tout prévoir? Ce n'est nullement le cas? On a vu que le "problème de l'arrêt", qui consiste à prédire si un ordinateur auquel on fournit un programme donné s'arrêtera, est un problème indécidable. Donc, même si nous disposions d'une "théorie du tout", elle serait incapable en général de prédire le comportement à long terme du système physique constitué par un ordinateur en fonction du programme qu'il est en train d'effectuer. On peut penser qu'on peut trouver un algorithme particulier qui prédit l'arrêt on non d'un système. C'est faux. Le théorème de Gödel montre qu'il existe des programmes pour lesquels aucun algorithme ne peut prédire l'arrêt ou la continuation infinie. La totalité des mathématiques qu'utilise la physique est contenue dans ZF (axiomatique de Zermelo- Fraenkel). Appelons T la théorie obtenue en ajoutant à ZF la partie nécessaire pour obtenir une théorie physique (par exemple la théorie du tout). Elle est donc envisagée comme un système formel. T est-elle capable de prédire le comportement (l'arrêt ou non), d'une machine de Turing programmée pour vérifier pour chacun des entiers successifs, un énoncé E ("V n P(n)") qui est indécidable au sens du théorème de Gödel? Si T est consistante, il n'est possible de prouver formellement dans T que ni E est vrai (la machine calculera indéfiniment) ni que E est faux (elle s'arrêtera pour une valeur de n pour laquelle laquelle P est faux). La réponse d'un mathématicien sera négative. En revanche, un raisonnement sémantique montrera que si T est consistante, la machine ne s'arrêtera pas, car cela signifie qu'on a trouvé une valeur de n pour laquelle P est faux et donc qu'on a prouvé la fausseté de E contrairement à ce qui a été postulé. Ce raisonnement n'est toutefois pas une preuve formelle, ce qui fait dire au mathématicien qu'il est impossible de démontrer E dans T. Le physicien acceptera la preuve car l'utilisation d'une théorie physique ne se limite pas à ses déductions purement formelles. Cela semble remettre en cause ce qui a été dit précédemment, que la théorie T, pour le physicien, est incapable de prédire le comportement de la machine de Turing considérée.

Mais, voici un exemple pour lequel l'impossibilité de prédiction concerne aussi bien le mathématicien que le physicien. L'adjonction à ZF de grands cardinaux peut rendre la théorie contradictoire (voir articles 3 "le programme de Hilbert et les indécidables). Le rajout de certains axiomes de grands cardinaux peut être telle que la théorie obtenue (ZFE) soit totalement inconnue au sens où non seulement elle n'est ni démontrable ni réfutable dans ZF, mais encore où on est dans l'incapacité d'avoir une opinion précise à son sujet. Soit une machine de Turing énumérant les théorèmes de ZFE, qui s'arrête lorsqu'elle a obtenu la démonstration de "1 = 2". Pour un physicien, la théorie T est-elle capable de prédire le comportement de cette machine? La réponse est cette fois négative, car cela consisterait à prédire la consistance de ZFE, ce qui n'est possible ni formellement dans le cadre de T. Nous retrouvons le résultat annoncé, qui n'est qu'une conséquence directe inévitable des limites des systèmes formels. Ce constat n'est nullement dû à une incertitude sur l'état initial, à une méconnaissance des lois qui régissent le fonctionnement de l'ordinateur ou à des effets quantiques et il existerait même dans un monde totalement classique. Il est impossible de construire une théorie qui prédise, en général, le comportement d'un ordinateur (ou d'une machine de Turing) en fonction d'un programme qu'on lui fait exécuter. C'est comme si on ne pouvait pas prévoir la vitesse d'arrivée au sol d'un caillou en fonction de la hauteur à laquelle il a été lâché. Ceci montre qu'il existe des objets simples et courants (les ordinateurs par exemple) dont les lois de fonctionnement sont connues et dont le comportement est cependant non prédictible. Ainsi, "même dans un univers simple, non quantique..., l'avenir continuerait de nous échapper" (Delahaye).

Conclusion de ce chapitre: Il existera toujours des parties de la réalité empirique qui échappent à la prédiction et sur lesquels toute théorie restera aveugle. C'est un autre aspect de la cécité empirique.

e) La cécité empirique: une maladie inévitable.

Dans un premier aspect, la cécité empirique peut, en étant aveugle à certaines parties de la réalité empirique, induire un programme de recherche tel qu'aucune expérience risquant de la mettre en échec ne puisse être conduite. Elle sera corroborée et considérée comme adéquate.

Le deuxième est lié au fait que toute théorie est dans l'incapacité de se prononcer quand des phénomènes sont exprimés par des énoncés indécidables dans le système formel qui la constitue. De plus, le programme de recherche induit par la théorie détermine les expériences faites en vue de tester ses prédictions. Ce programme ne pousse donc pas à expérimenter les domaines sur lesquels le théorie est muette, car cela n'aurait à priori pas d'incidence sur la théorie et il est possible que les concepts nécessaires pour une telle expérimentation n'existent pas. A l'époque de Maxwell, des tests sur la non-séparabilité n'auraient sans doute pas abouti, car il fallait des concepts issus de la mécanique quantique pour se poser la question.

Il résulte de ce qui précède que, quelle que soi la théorie considérée, il existera des phénomènes qu'elle ne pourra prédire (incomplétude prédictive) et en conséquence, certaines parties de la réalité empirique seront hors de son champ de pertinence. L'exemple de la machine de Turing peut sembler artificiel. Le théorème de Gödel a été le premier à être explicité pour montrer l'incomplétude de l'arithmétique avant de fournir plus tard des exemples d'indécidabilité plus naturel. Ainsi, trouver un énoncé empirique simple et naturel dont l'indécidabilité pourrait être établie dans "la théorie du tout" n'est pas actuellement une tâche à la portée des scientifiques. Mais cela ne remet pas en causes les conclusions de ce chapitre, la réalité empirique débordera toujours du champ de description théorique et nous ne disposeront jamais d'aucune théorie décrivant et prédisant la totalité de cette réalité.

4) Une conception à trois niveaux.

Nature possible de ce "quelque chose" dont on postule l'existence en refusant l'idéalisme radical.

a) Le représentable et le conceptualisable.

*Le représentable. C'est ce dont on peut avoir une image, claire et distincte. Les perceptions interprétées (ce qui est donné à la conscience, par opposition à ce qui est donné aux sens), sont représentables et représentées. On peut parler d'une partie de la réalité empirique, la "réalité phénoménale", qui est l'ensemble de nos perceptions interprétées. Tous les faits expérimentaux empiriques font partie de la réalité phénoménale, ils sont le constat de perceptions interprétées et sont représentables puisqu'ils se manifestent comme des images perceptives directes et conscientes.

*Le conceptualisable est ce dont on peut parler en termes descriptifs, sous forme verbale ou mathématique. Certains concepts sont représentables (table, force, état en physique classique). D'autres ne le sont pas (état superposé, enchevêtré ou non-séparabilité en physique quantique). Pour ces derniers, il est impossible d'en avoir une image mentale claire, mais il est possible d'en donner une description mathématique, ce que fait la mécanique quantique qui conceptualise ces notions.

b) Le réalisme des phénomènes.

Beaucoup de conceptions, réalistes ou non, suggèrent la réalité empirique comme comme une scène sur laquelle se déroulent les phénomènes que nous n'avons qu'à observer. C'est le point de vue qui considère un "face à face de l'homme et du monde" qu'on peut appeler "le réalisme des phénomènes". C'est un équivalent du réalisme des objets qui consiste à croire que les objets physiques existent, sont là et que nous les observons parce qu'ils sont là. L'acceptation du réalisme métaphysique en est une conséquence. Cette conception est même présente dans beaucoup de celles qui rejettent le réalisme métaphysique et qui nient l'existe en soi des objets en affirmant que nous n'avons un accès direct qu'aux phénomènes en nous contentant de prendre conscience de la réalité empirique de manière passive. Ce n'est pas que nous ne faisons pas d'effort, mais cela ressemble plus à celui que nous faisons en nous baissant pour ramasser un caillou qu'à celui qui consiste à créer quelque chose qui n'existerait pas sinon.

Les perceptions interprétées doivent être les éléments sur lesquels nous devons nous appuyer sans être considérées seulement comme de simples prises de conscience de quelque chose de préexistant qui serait la réalité empirique comme celle de l'image réaliste traditionnelle. En fait, aucun phénomène extérieur n'existe et nous sommes responsables de nos perceptions, d'une certaine manière nous créons la réalité phénoménale. Mais nous ne sommes pas libres de créer comme bon nous semble, certaines contraintes existent, la réalité empirique. Cette dernière est l'ensemble des conditions qui rendent possibles nos perceptions tout en les contraignant. Elle n'est pas donnée en tant que telle, mais c'est le cadre des actions, physiques ou psychiques que nous mettons en oeuvre dans le processus cognitif, ensemble des potentialités qui, lors de leur actualisation deviennent perceptibles et donnent naissance à nos perceptions. de façon imagée, la perception est à la potentialité ce que le résultat d'une mesure quantique est à la grandeur physique mesurée. Un phénomène n'est donc pas quelque chose que nous observons passivement, c'est une entité qui se manifeste lors d'une opération dans laquelle nous avons un rôle important à jouer.

Nos perceptions sont en un sens imposées de l'extérieur (la réalité phénoménale est l'ensemble de nos perceptions), nous pouvons avoir l'idée d'une réalité phénoménale qui n'existe pas encore, mais qui vient à l'existence dans le cours de notre tâtonnement. Mais ce à quoi nos recherches donnent existence n'est pas notre oeuvre propre. Le point de vue du réalisme des phénomènes semble erroné. La réalité empirique ne peut être considérée comme l'ensemble des phénomènes, de même que le monde ne peut considéré comme l'ensemble des objets. D'une certaine manière, nous fabriquons le réalité phénoménale à partir de la réalité empirique. Il faut donc abandonner le fameux face-à-face entre le sujet et le monde. Le deuxième niveau est celui de la réalité empirique dont le nom est impropre. Car sa réalité n'est pas constituée d'objets, forces, champs ou de quoi que ce soit de représentable, mais de l'ensemble des potentialités actualisables selon certaines contraintes qui nous empêchent la fabriquer selon notre bon vouloir. On retrouve sous cette forme l'idée du réalisme structurel. L'adéquation empirique ("adéquation phénoménale") des théories contradictoires provient de leur respect de la structure de la réalité empirique, des contraintes (voir ci-dessus) qu'elle implique. Il n'y a plus de réalité à laquelle peuvent faire référence des entités théoriques (elle n'est pas constituée d'objets physiques ayant un référent ni d'entités physiques au sens habituel du terme, mais de perceptions actualisées). De plus, si les théories physiques ne sont que des algorithmes, alors plusieurs théories peuvent rendre compte de la réalité phénoménale si ces algorithmes reflètent les contraintes structurelles imposées à la réalité empirique.

La réalité phénoménale est conceptualisable et représentable par définition. En revanche, la réalité empirique est conceptualisable (nous sommes capables de fabriquer des théories qui rendent de sa structure), mais pas représentable (elle est potentialité alors qu'une représentation est par essence actualisée). De plus, en raison de la sous-détermination des théories, elle n'est conceptualisable que de manière partielle, et il est impossible de recoller les différentes manières (équivalentes) de la conceptualiser pour en obtenir une représentation globale. (L'épistémologie de Quine comporte une autre thèse essentielle, dite « de la sous-détermination des théories par l'expérience ». On peut la résumer ainsi : deux théories différentes peuvent être empiriquement équivalentes ; elles peuvent être vérifiées et falsifiées par le même budget d'observations possibles, et cela même si l'on poursuivait indéfiniment, « jusque dans l'éternité », les observations et vérifications. La conséquence extrême et paradoxale en est l'impossibilité de concevoir le progrès scientifique comme une approche de la vérité).

On peut comparer cette situation à la complémentarité quantique (onde-particule) pour laquelle les deux descriptions sont complémentaires et incompatibles. On peut mesurer la position ou l'impulsion, mais les deux sont incompatibles. Mesurer l'une puis l'autre ne permet pas de connaître les deux à postériori. La réalité phénoménale est en quelque sorte une coupe actualisée donnant une représentation partielle de la réalité empirique. Chaque coupe est exclusive et ne permet pas de reconstituer une vue en perspective à travers l'image de plusieurs coupes différentes, comme en architecture.La non-représentabilité est due au fait qu'il n'est ni possible de connaître toutes les parties simultanément en totalité ni de reconstruire à postériori la globalité de la réalité empirique à partir des coupes partielles que sont les réalités phénoménales.

"La réalité empirique est la structure limite engendrée par l'ensemble des entités conceptuelles que nous utilisons pour être à même de décrire et de prédire les réalités phénoménales. Elle est donc liée directement aux capacités conceptuelles du cerveau humain même si elle reste hors de portée de d'une compréhension globale. C'est une limite à l'infini qui ne peut qu'être approchée par nos représentations finies tendant vers elle.

Cela peut rappeler le monde- Ω de Bonsack avec ici une infinité de chemins limites incompatibles. Pour le solipsisme convivial, la réalité phénoménale est le résultat de l'accrochage de chaque sujet à une branche particulière de la fonction d'onde de l'univers, actualisée éventuellement de manière différente, sans que cette différence puisse être perceptible. La fonction d'onde de l'univers est une des outils permettant de conceptualiser la réalité empirique, mais celle-ci ne doit pas lui être identifiée. Ce n'est qu'un des outils, issu d'une des théorie possibles pour modéliser la réalité phénoménale qui n'est pas conceptuellement épuisée par cette notion de fonction d'onde. La réalité empirique est en effet l'ensemble des conditions rendant possible l'émergence des réalités phénoménales, qui sont contraintes par la structure de l'esprit humain (dont l'induction au sens faible, le fait que certaines associations passées se reproduisent).

c) La nécessité d'un troisième niveau.

On peut alors se demander si la réalité empirique et la réalité phénoménologique épuisent le monde.

La physique contemporaine a progressivement abandonné l'exigence de représentabilité des concepts car il est impossible de se forger une image de nombre d'entre eux (espace-temps courbe de la relativité générale, concept d'état superposé, enchevêtrement des états de deux systèmes ayant interagi, non-séparabilité, concepts purement mathématiques de la théorie des super cordes). La réalité empirique au sens envisagé ici n'est pas représentable dans sa globalité, mais elle reste conceptualisable, la preuve, nous sommes capables d'en parler et d'en décrire les effets. Dans la conception du solipsisme convivial, c'est le fait que la représentation peut revêtir des formes différentes selon les sujets qui crée la diversité des réalités phénoménales individuelles à partir d'une réalité empirique unique. Cette unicité provient de ce que la structure de notre cerveau, supposée identique pour tous les hommes, détermine ce qui est conceptualisable. Les réalités phénoménologiques sont multiples car il est nécessaire de faire un choix de point de vue pour se représenter la réalité empirique (pourquoi? cela reste hors du champ de notre compréhension. Est-ce dû à la structure de notre cerveau...?). Tous sont potentiellement autorisés et il n'y a aucune raison pour que ce choix soit identique pour tous les sujets.

La réalité empirique est donc l'ensemble des potentialités actualisables; elle est asymptotiquement descriptibles par les entités que nous utilisons pour décrire et prédire les réalités phénoménales. Directement liée aux capacités conceptuelles du cerveau humain, c'est une construction pragmatique indispensable. Mais si on essaye de la penser comme un tout, c'est un monde étrange, non représentable, aux propriétés contre-intuitives.

Cette réalité empirique est inaccessible aux capacités conceptuelles d'un animal dont la conceptualisation est vraisemblablement très différente de la nôtre. Si nous pensons que la nôtre est meilleure et plus complète, alors il est possible d'envisager une capacité de conceptualisation qui serait supérieure à la nôtre. Croire l'inverse serait retomber dans la naïveté de certains savants 19è siècle qui s'imaginaient avoir tout découvert ou postuler comme Church que le cerveau humain est arrivé à un stade d'évolution qui lui permet de conceptualiser tout ce qui est conceptualisable, comme les fonctions récursives partielles suffisent à représenter toutes les fonctions calculables. Il est difficile de donner un sens à la thèse selon laquelle notre conceptualisation est meilleure et plus complète que celle du singe par exemple. Elle suppose qu'on puisse définir la notion "d'entité conceptualisable" (dans l'absolu) sans référence à un type de cerveau particulier comme celui de l'homme ou du singe. S'affranchir des limites du cerveau humain pour définir une notion qui lui est aussi fortement attachée semble une entreprise vouée à l'échec. Si on admet cette possibilité à titre d'hypothèse, la conséquence est que quelles que soient les évolutions futures de l'homme, des machines ou d'éventuels extraterrestres, aucune capacité cognitive ne pourra construire de concepts inaccessibles au cerveau humain. Cela rappelle les croyances anthropomorphes successivement réfutées (position de la terre au centre de l'univers...) pour être plausible.

On peut donc défendre l'idée selon laquelle il y a des choses non conceptualisables, pour nous ou pour tout système perceptif. Ce qui ne veut pas dire "qu'il existe des choses non conceptualisables" car cette manière d'en parler aurait une signification trop proche de nos concepts. On pourrait l'exprimer en disant que ce qui est conceptualisable n'épuise pas "tout", sans préciser ce qu'est ce "tout".

Cela définit un troisième niveau indispensable, dont on ne peut pas parler, qui est en même temps inexprimable. On peut le formuler de manière négative: "nos concepts n'épuisent pas tout". On ainsi introduit trois niveaux: le représentable, le conceptualisable et le non conceptualisable.

d) Les trois niveaux.

1) Quelque chose, dont on ne peut pas parler, mais, s'il le faut, qu'on ne peut caractériser que négativement. Dire qu'il existe est impropre mais le mentionner est déjà une sorte d'existence. Et c'est là que s'arrête le langage. C'est l'inconnaissable, domaine non conceptualisable pour l'homme, comme le domaine d'opérateur quantique est non conceptualisable pour un singe. Sa nécessité provient du refus de considérer que le conceptualisable épuise tout.

2) La réalité empirique qui est l'ensemble des potentialités dont l'actualisation, soumise aux contraintes qui les caractérisent, engendre les perceptions. Celles-ci ne s'actualisent que par l'action de la conscience individuelle au sein de la réalité empirique unique et virtuelle. Inconnu connaissable, la réalité empirique matérialise d'une certaine manière les conditions a priori de nos perceptions. Elle n'existe pas indépendamment de l'homme et c'est bien l'homme qui la crée. Mais l'homme ne fait rien pour la créer. Elle n'est que le moule de ses perceptions au sein de l'inconnaissable (la réalité empirique d'un animal est très différente et elle n'existe pas pour l'homme).

3) Les perceptions qui constituent la réalité phénoménale qui sont différentes chez chacun et sont l'apparence que prend la réalité empirique pour les individus. C'est le connu. Les perceptions ne sont pas neutres et objectives mais nous sont livrées à travers tous les filtres conceptuels du langage, de la culture, de l'éducation et les filtres physiques de nos sens.

"Nous ne fabriquons pas la réalité phénoménale directement à partir de la réalité empirique mais par actualisation à travers le moule de la réalité empirique, d'une portion de l'inconnaissable".

5) Conclusion.

La réflexion sur les limites de la connaissance nous a éloigné de l'environnement rassurant des théories scientifiques pour s'approcher de la métaphysique et de positions hors de portée de toute justification empirique et de nature purement philosophique. Elles ne sont pas vaines et ont une valeur liée à la réflexion pure qui permet de se forger pour soi-même une conception du monde, même si elle est au-delà de toute validation. C'est un objectif intéressant si on s'astreint à respecter une rigueur de raisonnement et une cohérence logique. Il peut apporter une réponse possible à certaines des énigmes présentées au cours des articles de cette réflexion sur les limites de la connaissance.

La conception qui est exposée, complétée par le solipsisme convivial est "ma lecture " du livre de Hervé Zwirn, qui est conforme aux exigence de la physique quantique au sens large. Elle est directement inspirée par les solutions actuellement acceptées du problème de la mesure quantique. Elle échappe de ce fait aux objections soulevées par la physique moderne contre le réalisme traditionnel. Elle rejette à la fois le réalisme métaphysique et le réalisme épistémique mais ce n'est pas une conception idéaliste pure. Elle permet de comprendre pourquoi plusieurs théories apparemment contradictoires ou incommensurables peuvent néanmoins décrire correctement la réalité phénoménale en évitant la fausse question du référent réel des entités théoriques ou le concept illusoire de vérité approximative.

La sous-détermination des théories par l'expérience est une conséquence du fait que nos théories ne sont que des algorithmes utiles pour prédire la réalité phénoménale. En conséquence, l'argument no miracle (du succès empirique) s'évanouit si on considère que les théories ne s'appliquent qu'à une partie de la réalité phénoménologique qui s'y prête et que de vastes portions leur échappent et leur échapperont toujours, et d'autre part, que leur réussite provient de de leur respect de la structure de la réalité empirique.

L'intersubjectivité s'explique si on croît à l'unicité de la réalité phénoménale et que les perceptions de différents sujets sont identiques. Le formalisme quantique fournit une explication cohérente même en l'absence de réalité externe préexistante. Mais si on suppose que qu'il y a autant de réalités phénoménales que de sujets différents, le solipsisme convivial permet de comprendre pourquoi il est impossible d'en prendre conscience. L'intersubjectivité est alors une illusion que nous n'avons aucun moyen de dissiper.

La résistance du réel provient de l'incapacité de nos structures mentales à élaborer une construction théorique formelle et une construction perceptuelle qui soient conjointement consistantes.

Cette conception emprunte certains traits à des positions opposées. Partiellement réaliste (tout n'est pas création de nos esprits), elle n'admet pas l'existence d'une réalité indépendante de l'homme. Les réalités empiriques et phénoménales n'existent que relativement à nos capacités perceptives (donc leur existence est de nature différente de celle postulée par les conceptions réalistes traditionnelles). L'inconnaissable n'a aucun attribut et on ne peut pas dire qu'il existe indépendamment de l'homme, conception partiellement idéaliste en ce sens que l'esprit humain y joue un rôle essentiel bien qu'il n'en soit pas le seul ingrédient: "L'esprit et le monde construisent conjointement l'esprit et le monde" (Putnam, cité en exergue). Cette conception fait jouer aux théories le rôle d'algorithme (forme d'instrumentalisme), mais le dépasse en proposant une explication de la réussite prédictive des algorithmes à travers un réalisme structurel. Et enfin, elle s'inscrit dans une perspective néo-kantienne.

Arrivé au terme de mes articles sur "les limites de la connaissance", je pense qu'une relecture depuis le début après un certain temps de réflexion permettra de nouveaux commentaires et de mûrir une propre conception qui ne sera sans doute jamais définitive.

votre commentaire

votre commentaire

-

Par amourdelapeinture le 20 Octobre 2011 à 20:22

J'ai été très intéressé par ce magistral développement de "philocours.com" qui illustre bien mes réflexions de mes articles sur les limites de la connaissance en ce qui concerne les théories scientifiques et le réel. Voir à ce sujet mon dernier article en préparation: les limites de la connaissance 6-8) Conclusion- la cécité empirique qui paraîtra prochainement.

Les théories scientifiques décrivent-elles la réalité ?

page créée le 13/08/2004

liens associés

Plan

I- La conception naïve de la théorie scientifique : les theories sont issues de l’experience

1) L’observation sans préjugés (ou subjectivité versus objectivité). B- Les faiblesses de l’induction

2) Induction et déduction.

3) L’inductivisme scientifique.

1) difficulté purement logique : dans une inférence inductive, la vérité des prémisses ne garantit pas la vérité de la conclusion II- Les théories ne precedent-elles pas l’expérience ?

2)Deuxième difficulté : le choix (et la sélection) des données.

3) Pas d’observation sans théorie1) Critique de l’inductivisme naïf : Hempel, Eléments d’Epistémologie. III- La sous-détermination des théories par l’expérience : le holisme scientifique

2) Popper et le falsificationnisme (l’expérience est réfutatrice, mais pas vérificatrice)1) Faut-il avoir confiance dans le critère de falsifiabilité ?

2) Le holisme scientifique (Quine)

Note historique : Galilée et Copernic, ou : croyaient-ils que la terre tournait ?3) La science est-elle vraie?

Note historique : la formation du concept d'atome au 19e.Conclusion

Nous avons soupçonné, à la fin de cours-histoire, que l’histoire n’est pas une science, car elle ne nous dit pas comment est le passé en soi, mais elle le reconstruit. Elle est, a-t-on dit, subjective, et non objective. Nous avons donc présupposé que la science, elle, se caractérise par une objectivité totale, et que les faits qu’elle décrit nous disent comment est réellement le monde en dehors de nous. Elle est le modèle supposé de la connaissance " vraie " du monde.

NB : C’est ce que croit le sens commun, cf. les pub qui se servent du cachet " c’est scientifique ", pour nous faire acheter le produit. " C’est scientifique " est synonyme de " c’est prouvé ", " c’est vrai ", " on ne peut pas le réfuter ", etc.

Sous sa forme raffinée, cette opinion commune prend le nom de scientisme : théorie selon laquelle la science nous donne une vérité absolue et indiscutable ; et qui a pour conséquence le rejet de toutes les autres formes culturelles (l’art, la religion, la philosophie), ainsi que les autres mentalités, hors du domaine de la connaissance.

Origine : Auguste Comte.

Or, les faits scientifiques sont-ils vraiment, contrairement aux faits historiques, non construits par l’homme ? Sont-ils entièrement objectifs et " vrais " ? Nous allons y répondre en réfléchissant sur les questions suivantes : Comment faisons-nous l’acquisition des théories scientifiques ? Les déduisons-nous directement de l’expérience, ou bien la précèdent-elles ? I.e., sont-elles la copie conforme du réel, ou bien une reconstruction de ce réel ?

Mais qu’est-ce qu’une théorie scientifique ?

Prenons par exemple la théorie astronomique suivante : " les planètes tournent selon des ellipses autour de leur soleil ".

Une théorie scientifique :

1) se présente donc sous la forme d’un énoncé universel ; elle porte sur la totalité des événements d’un type particulier, en tous lieux et en tout temps : ainsi, toutes les planètes, quelles qu’elles soient, tournent toujours autour de leur soleil suivant une orbite elliptique ;

2) explique le comportement des choses (connaissance du monde, description du réel)

3) prédit ce qui va arriver (on ne connaît pas seulement pour connaître mais aussi pour agir ; la théorie scientifique n’est donc pas une connaissance désinteressée contrairement à la philosophie et au sens le plus ancien de théorie).

I- La conception naïve de la théorie scientifique : les theories sont issues de l’experience

A. B. Wolfe, " Functional Economics ", in The Trend of Economics, R.G. Tugwell éd., Alfred Knopf, New York, 1924 : le scientifique idéal est un observateur sans préjugés (in Chalmers, op. cit., pp.34-35).

" Essayons d’imaginer un esprit doué d’une puissance et d’une étendue surhumaines, mais dont la logique soit semblable à la nôtre. S’il recourait à la méthode scientifique, sa démarche serait la suivante : en premier lieu, tous les faits seraient observés et enregistrés, sans sélection, ni évaluation a priori de leur importance relative. En second lieu, les faits observés et enregistrés seraient analysés, comparés et classés, sans hypothèses ni postulats autres que ceux qu’implique nécessairement la logique de la pensée. En troisième lieu, de cette analyse des faits, seraient tirés par induction des énoncés généraux affirmant des relations de classification ou de causalité entre ces faits. Quatrièmement, les recherches ultérieures seraient déductives tout autant qu’inductives, et utiliseraient les inférences tirées d’énoncés généraux antérieurement établis. "

Autre texte : Claude Bernard, Introduction à l’étude de la médecine expérimentale, Ed Delagrave, :

Si cette opinion est fondée, elle a pour conséquence l’inductivisme = manière empiriste de rendre compte de l’élaboration/origine des théories scientifiques. Le premier à l’avoir soutenue : F.Bacon. Les énoncés universels sont issus de l’observation d’une multitude de cas particuliers. C’est donc l’expérience qui précède la théorie, et en est l’origine et la base.

Pour savoir si l’opinion selon laquelle la science se caractérise par une observation sans préjugés est fondée, nous allons analyser la nature et la valeur du raisonnement inductif.

Le raisonnement inductif s’oppose au raisonnement déductif.a) L’induction

Raisonnement qui consiste à partir des cas particuliers et à généraliser à partir d’eux.

Exemple :

(1) t1 est (y), t2 aussi, t3 aussi, … tx (y)

(2) donc tous les t sont verts.

Raisonnement qui part du général pour aller vers le particulier.Et plus précisément, qui part de propositions tenues pour vraies pour en tirer des inférences.b) La déduction

Exemple :

(1) tous les hommes sont mortels

(2) or, Socrate est un homme

(3) donc Socrate est mortel

NB : ce serait un raisonnement non valide si on avait dit " nombreux " au lieu de " tous les ".

En général, on dit que la déduction est un raisonnement seulement formel, i.e., qui n’a rien à voir avec le réel ; il est l’objet de la " logique ", science du raisonnement. Ce que ne permet aucunement de savoir la déduction, c’est si les prémisses sont vraies ou non. Tout ce qu’elle nous permet de dire, c’est que si elles sont vraies, alors, la conclusion l’est aussi (i.e., de déduire des énoncés à partir d’autres énoncés).

Exemple :

(1) tous les chats ont cinq pattes

(2) Gromatou est mon chat

(3) Gromatou a cinq pattes

Est un raisonnement valide, car si (1) et (2) sont vraies, alors, (3) l’est aussi.

Voyons maintenant en quoi consiste l’inductivisme scientifique (inductivisme un peu plus sophistiqué que celui du sens commun), qui est, nous l’avons dit, le modèle le plus couramment présenté pour expliquer la découverte et l’élaboration des théories scientifiques.(in Chalmers, Qu'est-ce que la science ?,Ed la découverte, Paris,1987p.28)

1-Point de départ : collection, par l’observation, de tous les faitsa) Première phase : de l’observation à la théorie

2-ensuite, généralisation des faits observés, obtenue par induction

Exemple : On chauffe à de multiples reprises du métal, et on constate qu’à chaque fois, il se dilate ; on en conclut que le métal chauffé se dilate.

Le passage des prémisses à la conclusion est rendu légitime par trois conditions :

1- le nombre de constatations formant la base de la généralisation doit être élevé (les faits doivent être collectés en grand nombre)

En effet, on ne saurait légitimement conclure à la dilatation de tous les métaux chauffés sur la base d’une seule observation d’une barre de métal qui se dilate ; de même, on ne va pas conclure que tous les Australiens sont alcooliques si on observe un individu de cette nationalité soumis à cette dépendance. Il ne faut donc jamais se hâter pour formuler des conclusions !

2- les observations doivent être répétées dans une grande variété de conditions

Il ne suffit pas d’observer à de nombreuses reprises une barre de métal unique, ou de garder sous observation à longueur de temps un australien se saoulant toutes les nuits ou tous les matins. Il faut, pour que la généralisation soit légitime, que les conditions de l’observation soient différentes. Il faut chauffer des métaux différents, des barres de fer longues ou courtes, etc., à haute et basse pression, haute et basse température. La généralisation ne sera légitime que si le métal se dilate dans toutes ces conditions

3- aucun énoncé d’observation ne doit entrer en conflit avec la loi universelle qui en est tirée

Selon l’inductiviste, la science se base donc sur le principe d’induction, qui est le suivant : " si un grand nombre de A ont été observés dans des circonstances très variées, et si on observe que tous les A sans exception possèdent la propriété B, alors tous les A possèdent la propriété B " .

Une fois en possession de lois et de théories universelles, un scientifique devra en tirer diverses conséquences qui seront des explications et des prédictions. Par là, on revient à l’expérience initiale, mais à travers la théorie, et par une déduction. Chaque prédiction remplie de succès est une confirmation expérimentale de la théorie.b) Dernière phase : la déduction.

Exemple :

(1) de l’eau à peu près pure gèle à environ 0°C (si on lui en laisse le temps)

(2) le radiateur de ma voiture contient de l’eau à peu près pure

(3) si la température tombe en dessous de 0°C, l’eau du radiateur de ma voiture va geler (si on lui en laisse le temps)

Une théorie scientifique est donc, dans cette conception, toujours en relation directe avec l’expérience, qui a le premier et le dernier mot.

Dès le matin de son arrivée dans la ferme pour dindes, une dinde s’aperçut qu’on la nourrissait à 9h00 du matin. Toutefois, en bonne inductiviste, elle ne s’empressa pas d’en conclure quoi que ce soit. Elle attendit donc d’avoir observé de nombreuses fois qu’elle était nourrie à 9h00 du matin, et elle recueillit ces observations dans descirconstances fort différentes, les mercredis et jeudis, les jours chauds et les jours froids, les jours de pluie et les jours sans pluie. Chaque jour, elle ajoutait un nouvel énoncé d’observation à sa liste.

Elle recourut donc à un raisonnement inductif pour conclure : " je suis toujours nourrie à 9h00 du matin ". Or, cette conclusion se révéla fausse quand, un jour de noël, à la même heure, on lui tordit le cou.

Leçon de l’histoire : le raisonnement inductif se caractérise donc par le fait que toutes les prémisses peuvent être vraies et pourtant mener à une conclusion fausse. Si à tel moment la dinde a constaté qu’elle a été nourrie, il se peut toujours que le moment d’après, elle ne le soit pas. L’induction est un raisonnement non fondé logiquement.

Problème : si la science est fondée sur une démarche inductive, alors, elle n’est pas fondée !

De plus, la clause des " circonstances fort variées ", à laquelle tiennent tant les inductivistes, est elle-même criticable . En effet, ce que les inductivistes ignorent, ou ne rendent en tout cas nullement compte, c’est que s’il y a des données à recueillir, et ce, dans des circonstances fort variées, toutes les données n’ont pas d’intérêt, de même que toutes les circonstances.2)Deuxième difficulté : le choix (et la sélection) des données.

On ne peut observer sans " préjugés ", et le scientifique qui essaierait de le faire, n’aboutirait à aucun résultat : Chalmers, op. cit., pp.66-67 –un exemple d’expérimentation en laboratoire (Hertz).